1.本轮人工智能革命的起因和意义

本轮人工智能革命发端于微软旗下OpenAI发布的ChatGPT模型,该模型在自然语言处理方面展现出卓越的性能。其底层技术延续了谷歌于2017年提出的Transformer算法,核心思想是为机器提供足够的参数量和自由度,辅以大量数据进行暴力训练,从而实现量变引发质变的“涌现(Emergent)”效果。

Emergent 能力的三个示例:执行算术、参加大学水平考试和识别单词含义

资料来源:Emergent Abilities of Large Language Models(2022)

长期以来,语言一直被认为是人类独有的交流方式,它承载了思想在较低维度中的映射,体现了人类的抽象和概括能力。因此,自然语言处理技术被誉为“人工智能皇冠上的明珠”。与传统人工智能模型不同,大语言模型在对话中展示出类似于人类的理解、推理、演绎、类比能力,即所谓“思维链”。过去,这样的能力被认为是人和机器学习的本质区别。基于“思维链”的推理能力使得模型无需再进行复杂的训练,只需在提问时附加提示即可得到正确结果。这完全体现了人工智能模型对人类高级思维能力的模仿,进而使得人工智能应用领域得到极大的拓展。就像iPhone让手机变成了“人类器官”,并且让互联网触手可及,ChatGPT作为终极的调用算力和数据的方式,有可能使人工智能从完成有限任务的范畴拓展到几乎能够替代或协助人类进行所有思考任务。正如黄仁勋所说,这是人工智能的“iPhone时刻”。

ChatGPT背后的理论基础Transformer架构早在2017年就已提出,但巨头们对于投入数十亿级别的资金一直持保守态度。ChatGPT的出现促成了一个行业共识——只要投入海量数据来训练足够大参数的模型,就能够实现惊人的性能提升。

在国内,AI大模型长期发展缓慢,但自ChatGPT问世以来,短短几个月内涌现出了多个媲美GPT-3的大模型。

2.算力、应用等环节的机遇与挑战

大模型对产业链的拉动主要体现在上游的算力环节和下游的应用环节。

算力环节主要受益于模型规模的增长。近年来,大型语言模型(LLM)的规模以每年10倍的速度增长,2018年的BERT仅有1亿参数量级,到了2020年,GPT-3的参数量已达到百亿量级,2022年初发布的GPT-3.5更是高达1750亿参数(数据来源:《Large Language Models: A New Moore's Law?》,Julien Simon,Hugging Face)。即使不考虑训练数据集的增加,参数量的增长也带动了训练算力需求的快速提升。同时,随着越来越多的应用和大模型结合,推理阶段的算力需求也有望出现爆发式增长。TrendForce集邦咨询预测,2023年,AI服务器出货量将近120万台,同比增长38%。2022至2026年,器件、AI服务器出货量年复合增长率将达到22%,AI芯片2023年出货量预计将增长46%。

人工智能模型的算力需求呈现指数级增长

资料来源:Compute Trends Across Three Eras of Machine Learning(2022)

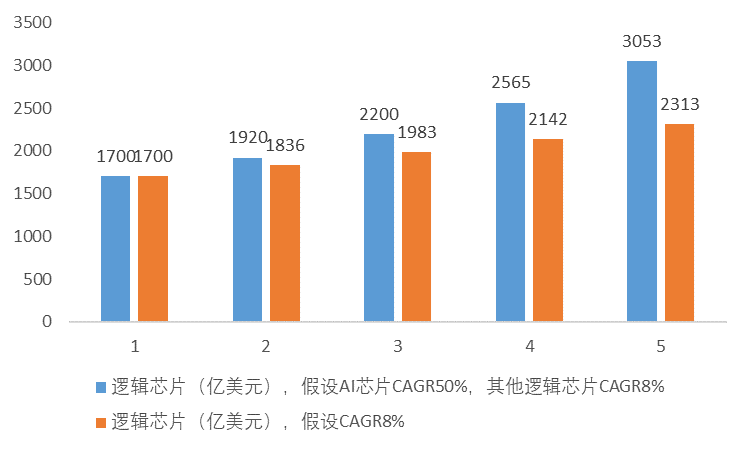

AI给逻辑芯片带来的增量测算

资料来源:上银基金权益投研部

在应用层面,人工智能可能带动传媒影视、游戏等行业的爆发式增长,同时也会促使机器人等新应用落地。

以机器人为例,一个简单的“拿薯片”指令就涉及多个计划步骤:例如走到抽屉旁,打开最上面的抽屉,拿起绿色的薯片,放在柜台上。传统的机器人很难完整执行此类复合型任务,主要困难集中在两个方面:

首先,传统机器人的操作流程通常从工程师开始,需要不断编写新代码和规则来纠正机器人的行为。这个过程缓慢、昂贵且低效,需要多次交互才能使机器人正常运行。

其次,机器人通常在明确具体任务和奖励的情况下表现最好,但在学习执行多步骤任务和推理抽象、模棱两可的指令方面存在困难。

然而,以ChatGPT为代表的大模型开启了一种新的机器人范式。一方面,大模型允许非技术用户参与控制回路,可以直接为机器人场景生成代码,在没有任何微调的情况下,利用大模型的知识来控制不同的机器人动作,以完成各种任务。另一方面,大模型也能够理解微妙的语句,例如“我刚刚锻炼过,可以给我拿一份健康的零食吗?”

类似的人工智能技术也有望在传媒影视、游戏等领域带来爆发式增长,比如通过大模型的智能和创造力,实现更出色的艺术创作。

大模型的出现改善了机器人对环境的适应性

资料来源:微软

然而,大模型的落地也面临一些挑战。

首先,大模型对计算资源的要求很高,需要大规模的计算设备和存储空间,这对企业和组织的投入提出了挑战。

其次,大模型的训练和部署需要处理大规模的数据集,而数据的质量和隐私问题也是需要考虑的重要因素。此外,大模型的复杂性也增加了模型可解释性的难度,这在某些领域,如法律和医疗等敏感应用中尤为重要。

总的来说,上银基金认为,算力和应用环节在大模型发展中具有重要地位。算力需求的增长将推动硬件产业的发展,并催生出更多高性能的AI服务器和芯片。同时,大模型的广泛应用将为各行各业带来创新和突破,但也需要应对算力、数据、模型解释性等方面的挑战,以实现大模型技术的可持续发展和应用的成功。

3.国内人工智能相关投资机会的展望

从投资角度来看,上银基金指出,算力板块直接受益于产业趋势,随着海量数据的收集、清洗、计算、训练和传输需求的增长,将带来算力和网络的迭代升级,利好AI数据中心和边缘高速计算所使用的GPU、CPU、FPGA、ASIC、HBM存储器、3D NAND、光芯片等。国外GPU的严重缺货,以及供应链的多元化需求也为国产AI芯片、服务器带来了适配机会。大模型的发展阶段是黄金窗口期,国内的算力芯片厂商具备良好的入局机会,相关的龙头企业有望明显受益。

此前,由于商业模式的缺陷,传媒影视、游戏和互联网软件等应用板块的估值普遍较低。因此,上银基金表示,AI应用行情的核心逻辑是用AI改造传统的商业模式,实现业绩与估值的戴维斯双击:需求端通过AI赋能提升用户体验,带来渗透率/斜率加快,供给端降本增效,释放更多产能,业务结构端提升软件算法平台权重,提升估值。当前,应用板块的估值修复基本完成,行情将进入逻辑驱动和业务驱动的第二阶段。在这个阶段,投资者应重点考虑业务的可持续性以及人工智能使用成本与客户需求的匹配度。

尽管目前人工智能仍处于产业趋势形成阶段,大模型和应用的格局不易判断,受事件催化影响较大,但该阶段正是成长股投资的最佳阶段,格局清晰后有望进入成长股的“价值投资”阶段,因此,上银基金认为,可以密切关注算力上游芯片放量以及下游AI服务器客户需求情况,并关注应用领域的真实客户需求;同时,投资者可以对机器人等具有现象级潜力的产品的落地保持期待,并结合行业发展动态理性投资决策。

本文内容由互联网用户自发贡献,该文观点仅代表作者本人。如发现本站有涉嫌抄袭侵权/违法违规的内容,请发送邮件至 3587015498@qq.com 举报,一经查实,本站将立刻删除。本文链接:https://www.xmnhj.com/h/192878.html